GPTDAOCN-e/acc on Nostr: ϊ╝αίΝΨίβρύγΕύπαίψΗΎ╝γίοΓϊ╜ΧώΑγϋ┐ΘύΚ╣ί╛Βύσ║ώΩ┤ώΑΚόΜσόΠΡίΞΘό╖▒ί║οίφοϊ╣ιόΑπϋΔ╜ ...

ϊ╝αίΝΨίβρύγΕύπαίψΗΎ╝γίοΓϊ╜ΧώΑγϋ┐ΘύΚ╣ί╛Βύσ║ώΩ┤ώΑΚόΜσόΠΡίΞΘό╖▒ί║οίφοϊ╣ιόΑπϋΔ╜

ϋ┐βί╝ιίδ╛ϋπμώΘΛϊ║Ηό╖▒ί║οίφοϊ╣ιϊ╝αίΝΨίβρύγΕίθ║όευίΟθύΡΗΎ╝Νί╝║ϋ░ΔύΚ╣ί╛Βύσ║ώΩ┤ίψ╣ϊ╝αίΝΨίβρώΑΚόΜσύγΕώΘΞϋοΒόΑπήΑΓϊ╗ξϊ╕Μόαψϋψού╗Ηϋπμϋψ╗Ύ╝γ

ϊ╕╗ϋοΒίΗΖίχ╣

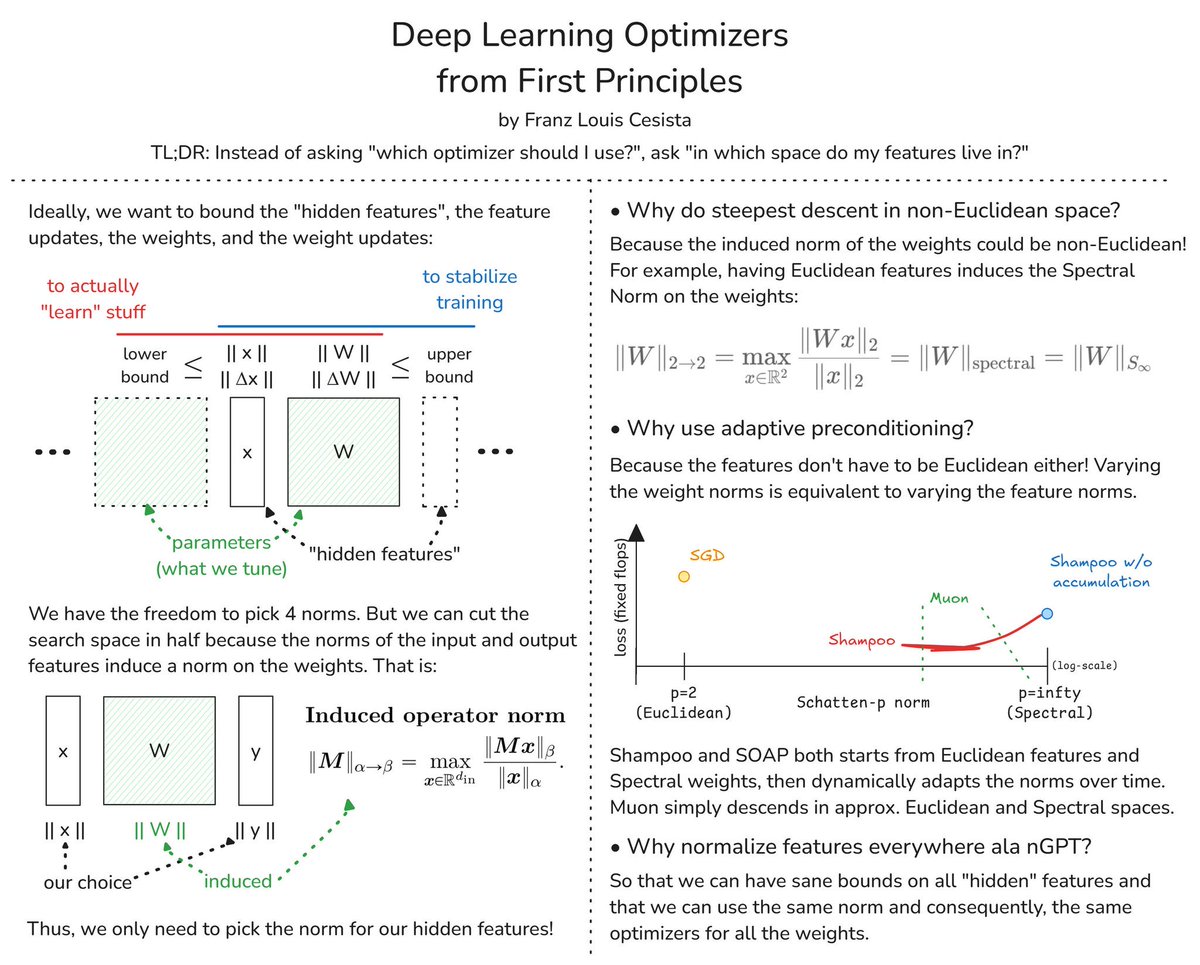

1. ύΚ╣ί╛Βύσ║ώΩ┤ϊ╕Οϊ╝αίΝΨίβρώΑΚόΜσΎ╝γ

- όΠΡίΘ║ώΩχώλαύγΕόΨ╣ί╝Πϊ╕ΞίΗΞόαψέΑεόΙΣϋψξύΦρίΥςϊ╕ςϊ╝αίΝΨίβρΎ╝θέΑζΎ╝ΝϋΑΝόαψέΑεόΙΣύγΕύΚ╣ί╛ΒίερίΥςϊ╕ςύσ║ώΩ┤ϊ╕φΎ╝θέΑζ

2. ύ║οόζθώγΡϋΩΠύΚ╣ί╛ΒΎ╝γ

- ύδχόιΘόαψώΑγϋ┐Θύ║οόζθέΑεώγΡϋΩΠύΚ╣ί╛ΒέΑζήΑΒύΚ╣ί╛Βόδ┤όΨ░ήΑΒόζΔώΘΞίΤΝόζΔώΘΞόδ┤όΨ░όζξύρ│ίχγϋχφύ╗ΔήΑΓ

- ί╖οϊ╛πί▒Χύν║ϊ║ΗίΠΓόΧ░Ύ╝ΙόΙΣϊ╗υώεΑϋοΒϋ░ΔόΧ┤ύγΕίΗΖίχ╣Ύ╝ΚίΤΝώγΡϋΩΠύΚ╣ί╛Βϊ╣ΜώΩ┤ύγΕίΖ│ύ│╗ήΑΓ

3. ώζηόυπίΘιώΘΝί╛Ωύσ║ώΩ┤ϊ╕φύγΕόεΑώΑθϊ╕ΜώβΞΎ╝γ

- ίερώζηόυπίΘιώΘΝί╛Ωύσ║ώΩ┤ϊ╕φϊ╜┐ύΦρόεΑώΑθϊ╕ΜώβΞΎ╝Νίδιϊ╕║όζΔώΘΞύγΕϋΝΔόΧ░ίΠψϋΔ╜όαψώζηόυπίΘιώΘΝί╛ΩύγΕήΑΓ

- ύΚ╣ί╛ΒίΖ╖όεΚόυπίΘιώΘΝί╛Ωί▒ηόΑπόΩ╢Ύ╝Νϊ╝γίερόζΔώΘΞϊ╕Λί╝ΧίΖξϋ░▒ϋΝΔόΧ░ήΑΓ

4. ϋΘςώΑΓί║ΦώλΕίνΕύΡΗΎ╝γ

- ϊ╜┐ύΦρϋΘςώΑΓί║ΦώλΕίνΕύΡΗΎ╝Νίδιϊ╕║ύΚ╣ί╛Βϊ╕Ξί┐ΖόαψόυπίΘιώΘΝί╛ΩύγΕήΑΓόΦ╣ίΠαόζΔώΘΞϋΝΔόΧ░ύδ╕ί╜Υϊ║ΟόΦ╣ίΠαύΚ╣ί╛ΒϋΝΔόΧ░ήΑΓ

5. ϋψ▒ίψ╝ύχΩίφΡϋΝΔόΧ░Ύ╝γ

- ώΑγϋ┐Θϋ╛ΥίΖξίΤΝϋ╛ΥίΘ║ύΚ╣ί╛ΒύγΕϋΝΔόΧ░ί╝ΧίΖξόζΔώΘΞϊ╕ΛύγΕϋΝΔόΧ░ήΑΓ

- ίΠςώεΑώΑΚόΜσώγΡϋΩΠύΚ╣ί╛ΒύγΕϋΝΔόΧ░ήΑΓ

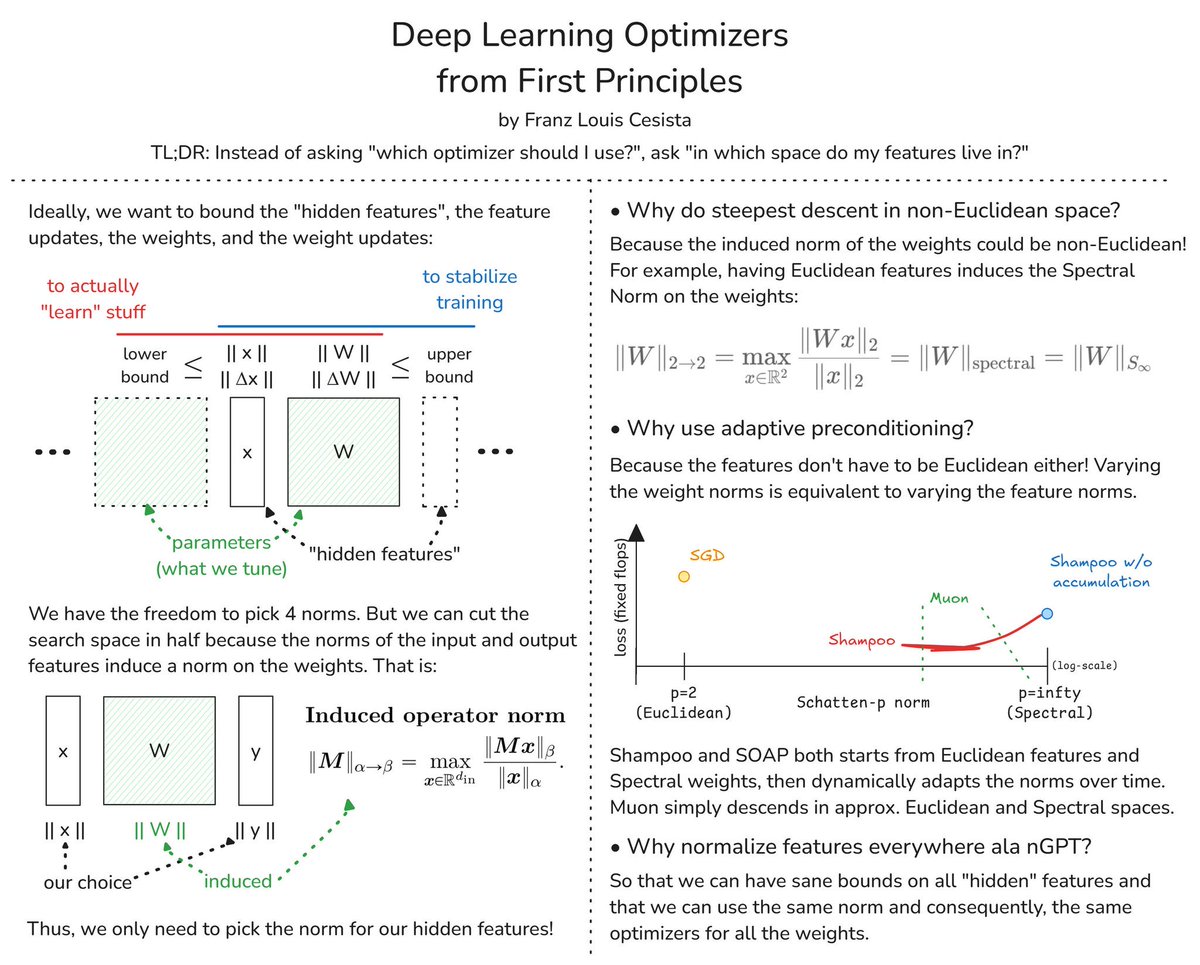

6. ϊ╕ΞίΡΝϊ╝αίΝΨίβρύγΕόψΦϋ╛ΔΎ╝γ

- ίδ╛ϋκρί▒Χύν║ϊ║Ηϊ╕ΞίΡΝϊ╝αίΝΨίβρΎ╝ΙSGDήΑΒShampooήΑΒMuonύφΚΎ╝Κίερϊ╕ΞίΡΝϋΝΔόΧ░ϊ╕ΜΎ╝ΙίοΓSchatten-pίΤΝϋ░▒Ύ╝ΚϋκρύΟ░ύγΕόΞθίν▒ήΑΓ

- ShampooίΤΝSOAPϊ╗ΟόυπίΘιώΘΝί╛ΩύΚ╣ί╛ΒίΤΝϋ░▒όζΔώΘΞί╝ΑίπΜΎ╝Νί╣╢ίΛρόΑΒϋ░ΔόΧ┤ϋΝΔόΧ░Ύ╝δMuonίΙβίερϋ┐Σϊ╝╝όυπίΘιώΘΝί╛ΩίΤΝϋ░▒ύσ║ώΩ┤ϊ╕ΜώβΞήΑΓ

7. GPTώμΟόι╝ϊ╕Μί╜Τϊ╕ΑίΝΨόΚΑόεΚύΚ╣ί╛ΒύγΕίΟθίδιΎ╝γ

- ύκχϊ┐ζόΚΑόεΚέΑεώγΡϋΩΠέΑζύΚ╣ί╛ΒόεΚύδ╕ίΡΝύΧΝώβΡΎ╝Νϊ╗ΟϋΑΝίΠψϊ╗ξίερύδ╕ίΡΝϋπΕϋΝΔϊ╕Μϊ╜┐ύΦρύδ╕ίΡΝϊ╝αίΝΨίβρήΑΓ

όΑ╗ύ╗Υ

ϋ┐βί╝ιίδ╛ί╝║ϋ░Δϊ║Ηίερό╖▒ί║οίφοϊ╣ιϊ╕φΎ╝ΝύΡΗϋπμύΚ╣ί╛ΒόΚΑίερύγΕόΧ░ίφούσ║ώΩ┤ίψ╣ϊ║ΟώΑΚόΜσίΡΙώΑΓύγΕϊ╝αίΝΨύφΨύΧξϋΘ│ίΖ│ώΘΞϋοΒήΑΓώΑγϋ┐ΘίΡΙύΡΗώΑΚόΜσίΤΝϋ░ΔόΧ┤ϋ┐βϊ║δύσ║ώΩ┤Ύ╝ΝίΠψϊ╗ξόΠΡώταόρκίηΜϋχφύ╗ΔύγΕόΧΙύΟΘίΤΝόΧΙόηεήΑΓ

ϋ┐βί╝ιίδ╛ϋπμώΘΛϊ║Ηό╖▒ί║οίφοϊ╣ιϊ╝αίΝΨίβρύγΕίθ║όευίΟθύΡΗΎ╝Νί╝║ϋ░ΔύΚ╣ί╛Βύσ║ώΩ┤ίψ╣ϊ╝αίΝΨίβρώΑΚόΜσύγΕώΘΞϋοΒόΑπήΑΓϊ╗ξϊ╕Μόαψϋψού╗Ηϋπμϋψ╗Ύ╝γ

ϊ╕╗ϋοΒίΗΖίχ╣

1. ύΚ╣ί╛Βύσ║ώΩ┤ϊ╕Οϊ╝αίΝΨίβρώΑΚόΜσΎ╝γ

- όΠΡίΘ║ώΩχώλαύγΕόΨ╣ί╝Πϊ╕ΞίΗΞόαψέΑεόΙΣϋψξύΦρίΥςϊ╕ςϊ╝αίΝΨίβρΎ╝θέΑζΎ╝ΝϋΑΝόαψέΑεόΙΣύγΕύΚ╣ί╛ΒίερίΥςϊ╕ςύσ║ώΩ┤ϊ╕φΎ╝θέΑζ

2. ύ║οόζθώγΡϋΩΠύΚ╣ί╛ΒΎ╝γ

- ύδχόιΘόαψώΑγϋ┐Θύ║οόζθέΑεώγΡϋΩΠύΚ╣ί╛ΒέΑζήΑΒύΚ╣ί╛Βόδ┤όΨ░ήΑΒόζΔώΘΞίΤΝόζΔώΘΞόδ┤όΨ░όζξύρ│ίχγϋχφύ╗ΔήΑΓ

- ί╖οϊ╛πί▒Χύν║ϊ║ΗίΠΓόΧ░Ύ╝ΙόΙΣϊ╗υώεΑϋοΒϋ░ΔόΧ┤ύγΕίΗΖίχ╣Ύ╝ΚίΤΝώγΡϋΩΠύΚ╣ί╛Βϊ╣ΜώΩ┤ύγΕίΖ│ύ│╗ήΑΓ

3. ώζηόυπίΘιώΘΝί╛Ωύσ║ώΩ┤ϊ╕φύγΕόεΑώΑθϊ╕ΜώβΞΎ╝γ

- ίερώζηόυπίΘιώΘΝί╛Ωύσ║ώΩ┤ϊ╕φϊ╜┐ύΦρόεΑώΑθϊ╕ΜώβΞΎ╝Νίδιϊ╕║όζΔώΘΞύγΕϋΝΔόΧ░ίΠψϋΔ╜όαψώζηόυπίΘιώΘΝί╛ΩύγΕήΑΓ

- ύΚ╣ί╛ΒίΖ╖όεΚόυπίΘιώΘΝί╛Ωί▒ηόΑπόΩ╢Ύ╝Νϊ╝γίερόζΔώΘΞϊ╕Λί╝ΧίΖξϋ░▒ϋΝΔόΧ░ήΑΓ

4. ϋΘςώΑΓί║ΦώλΕίνΕύΡΗΎ╝γ

- ϊ╜┐ύΦρϋΘςώΑΓί║ΦώλΕίνΕύΡΗΎ╝Νίδιϊ╕║ύΚ╣ί╛Βϊ╕Ξί┐ΖόαψόυπίΘιώΘΝί╛ΩύγΕήΑΓόΦ╣ίΠαόζΔώΘΞϋΝΔόΧ░ύδ╕ί╜Υϊ║ΟόΦ╣ίΠαύΚ╣ί╛ΒϋΝΔόΧ░ήΑΓ

5. ϋψ▒ίψ╝ύχΩίφΡϋΝΔόΧ░Ύ╝γ

- ώΑγϋ┐Θϋ╛ΥίΖξίΤΝϋ╛ΥίΘ║ύΚ╣ί╛ΒύγΕϋΝΔόΧ░ί╝ΧίΖξόζΔώΘΞϊ╕ΛύγΕϋΝΔόΧ░ήΑΓ

- ίΠςώεΑώΑΚόΜσώγΡϋΩΠύΚ╣ί╛ΒύγΕϋΝΔόΧ░ήΑΓ

6. ϊ╕ΞίΡΝϊ╝αίΝΨίβρύγΕόψΦϋ╛ΔΎ╝γ

- ίδ╛ϋκρί▒Χύν║ϊ║Ηϊ╕ΞίΡΝϊ╝αίΝΨίβρΎ╝ΙSGDήΑΒShampooήΑΒMuonύφΚΎ╝Κίερϊ╕ΞίΡΝϋΝΔόΧ░ϊ╕ΜΎ╝ΙίοΓSchatten-pίΤΝϋ░▒Ύ╝ΚϋκρύΟ░ύγΕόΞθίν▒ήΑΓ

- ShampooίΤΝSOAPϊ╗ΟόυπίΘιώΘΝί╛ΩύΚ╣ί╛ΒίΤΝϋ░▒όζΔώΘΞί╝ΑίπΜΎ╝Νί╣╢ίΛρόΑΒϋ░ΔόΧ┤ϋΝΔόΧ░Ύ╝δMuonίΙβίερϋ┐Σϊ╝╝όυπίΘιώΘΝί╛ΩίΤΝϋ░▒ύσ║ώΩ┤ϊ╕ΜώβΞήΑΓ

7. GPTώμΟόι╝ϊ╕Μί╜Τϊ╕ΑίΝΨόΚΑόεΚύΚ╣ί╛ΒύγΕίΟθίδιΎ╝γ

- ύκχϊ┐ζόΚΑόεΚέΑεώγΡϋΩΠέΑζύΚ╣ί╛ΒόεΚύδ╕ίΡΝύΧΝώβΡΎ╝Νϊ╗ΟϋΑΝίΠψϊ╗ξίερύδ╕ίΡΝϋπΕϋΝΔϊ╕Μϊ╜┐ύΦρύδ╕ίΡΝϊ╝αίΝΨίβρήΑΓ

όΑ╗ύ╗Υ

ϋ┐βί╝ιίδ╛ί╝║ϋ░Δϊ║Ηίερό╖▒ί║οίφοϊ╣ιϊ╕φΎ╝ΝύΡΗϋπμύΚ╣ί╛ΒόΚΑίερύγΕόΧ░ίφούσ║ώΩ┤ίψ╣ϊ║ΟώΑΚόΜσίΡΙώΑΓύγΕϊ╝αίΝΨύφΨύΧξϋΘ│ίΖ│ώΘΞϋοΒήΑΓώΑγϋ┐ΘίΡΙύΡΗώΑΚόΜσίΤΝϋ░ΔόΧ┤ϋ┐βϊ║δύσ║ώΩ┤Ύ╝ΝίΠψϊ╗ξόΠΡώταόρκίηΜϋχφύ╗ΔύγΕόΧΙύΟΘίΤΝόΧΙόηεήΑΓ