GPTDAOCN-e/acc on Nostr: 机器学习中的秘密武器:全面解读正则化技术 ...

机器学习中的秘密武器:全面解读正则化技术

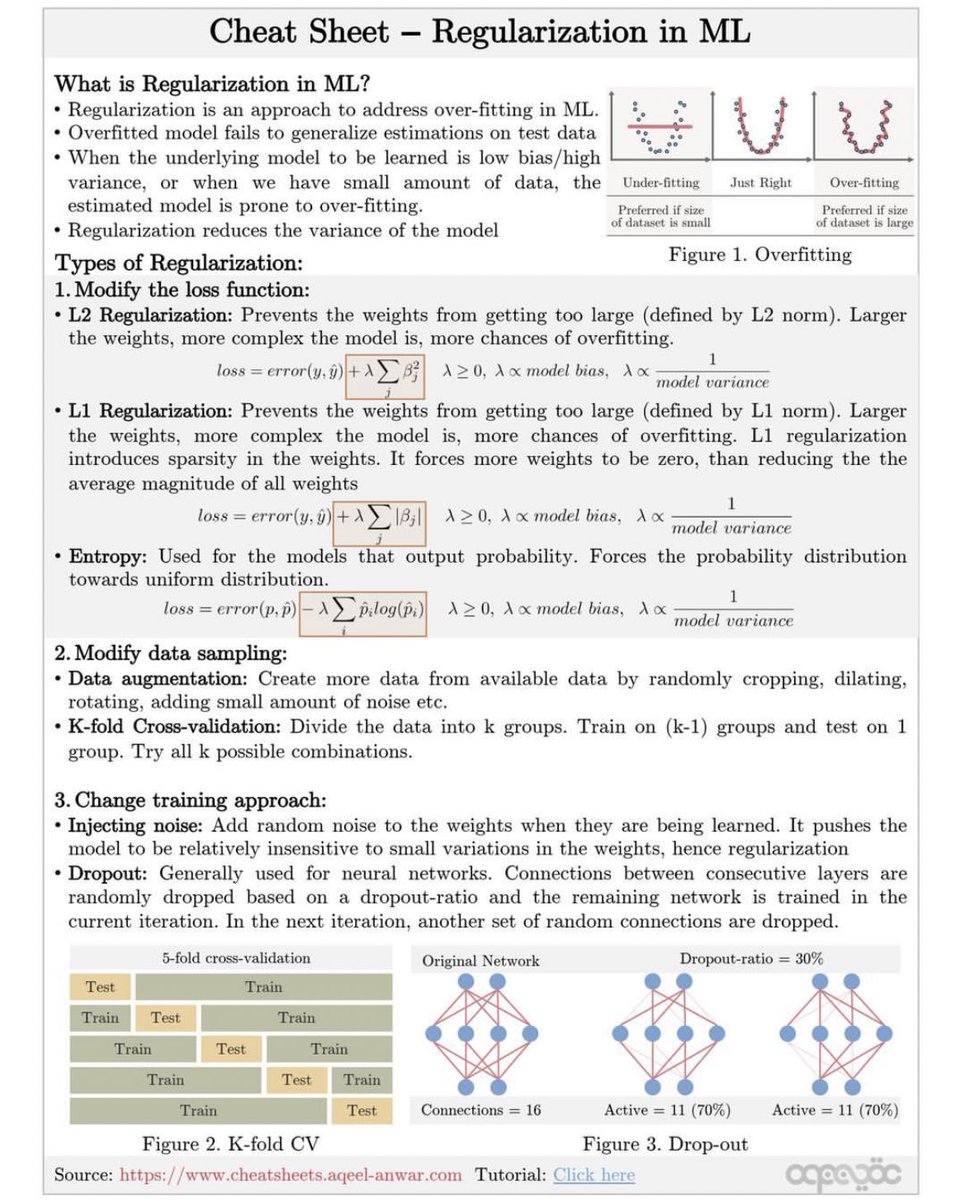

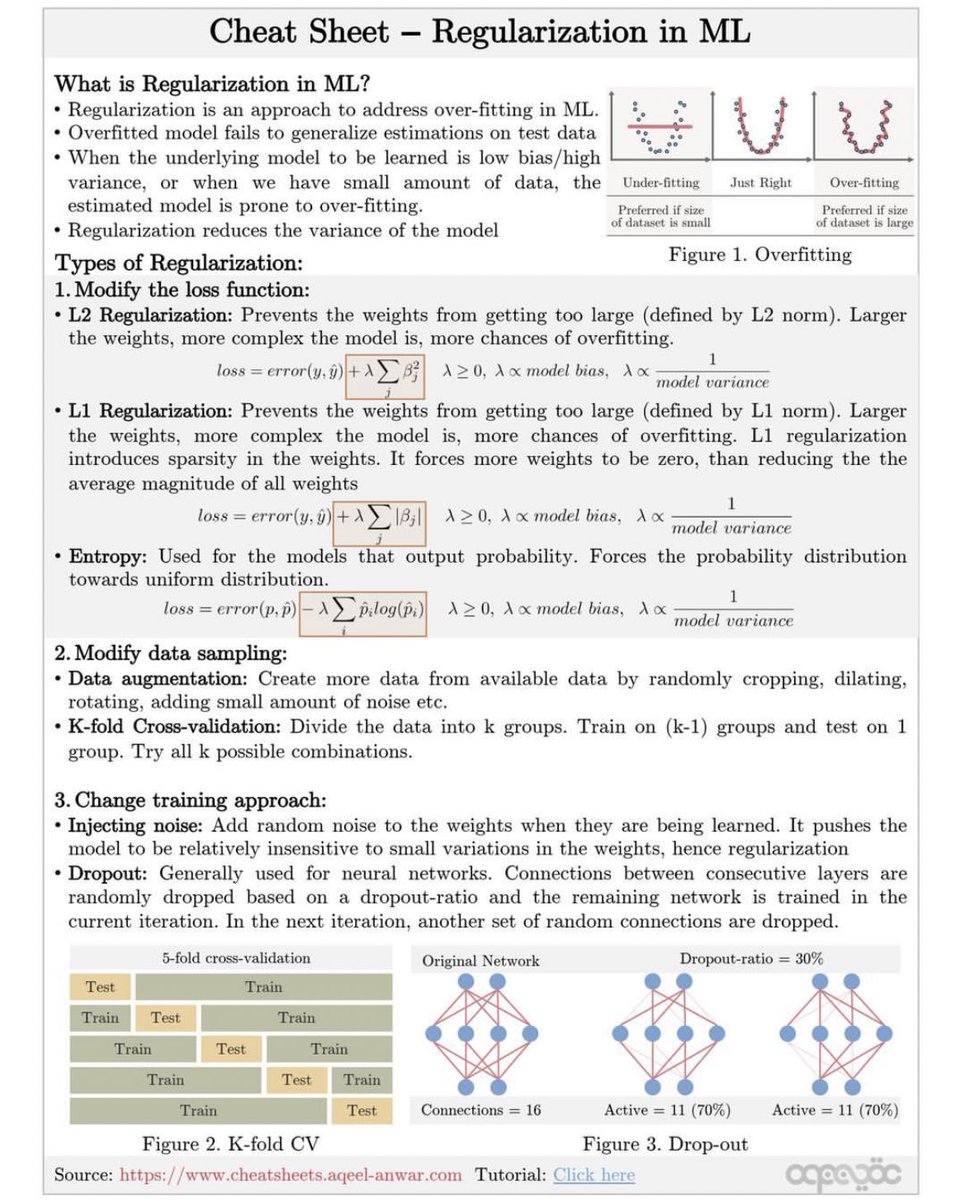

什么是机器学习中的正则化?

- 定义:正则化是一种解决过拟合问题的方法。

- 目的:防止模型在测试数据上泛化失败,即使在小数据集上也能避免过拟合。

- 效果:通过引入正则化,模型的方差会减小,从而提升其泛化能力。

正则化的类型:

1. 修改损失函数:

- L2 正则化:

- 作用:防止权重值过大(使用L2范数)。

- 公式:+\lambda\sum\beta_{j}^2)

- 效果:引入较大的权重会增加复杂度,减少过拟合。

- L1 正则化:

- 作用:防止权重值过大(使用L1范数),引入稀疏性。

- 公式:+\lambda\sum|\beta_{j}|)

- 效果:迫使更多权重为零,降低模型复杂度。

- 熵正则化:

- 作用:用于输出概率的模型,迫使概率分布趋向均匀。

- 公式:-\lambda\sum\hat{p}_{i}\log(\hat{p}_{i}))

2. 修改数据采样:

- 数据增强 (Data Augmentation):

- 方法:通过随机裁剪、旋转、添加噪声等方式从现有数据中生成更多数据。

- K折交叉验证 (K-fold Cross-validation):

- 方法:将数据分成k组,每次用k-1组训练,用剩下一组测试,重复k次。

3. 改变训练方法:

- 注入噪声 (Injecting Noise):

- 方法:在学习过程中向权重注入随机噪声,使模型对小变动不敏感,从而实现正则化。

- 丢弃法 (Dropout):

- 方法:在神经网络中随机丢弃部分连接,根据丢弃比例进行多次训练。

什么是机器学习中的正则化?

- 定义:正则化是一种解决过拟合问题的方法。

- 目的:防止模型在测试数据上泛化失败,即使在小数据集上也能避免过拟合。

- 效果:通过引入正则化,模型的方差会减小,从而提升其泛化能力。

正则化的类型:

1. 修改损失函数:

- L2 正则化:

- 作用:防止权重值过大(使用L2范数)。

- 公式:+\lambda\sum\beta_{j}^2)

- 效果:引入较大的权重会增加复杂度,减少过拟合。

- L1 正则化:

- 作用:防止权重值过大(使用L1范数),引入稀疏性。

- 公式:+\lambda\sum|\beta_{j}|)

- 效果:迫使更多权重为零,降低模型复杂度。

- 熵正则化:

- 作用:用于输出概率的模型,迫使概率分布趋向均匀。

- 公式:-\lambda\sum\hat{p}_{i}\log(\hat{p}_{i}))

2. 修改数据采样:

- 数据增强 (Data Augmentation):

- 方法:通过随机裁剪、旋转、添加噪声等方式从现有数据中生成更多数据。

- K折交叉验证 (K-fold Cross-validation):

- 方法:将数据分成k组,每次用k-1组训练,用剩下一组测试,重复k次。

3. 改变训练方法:

- 注入噪声 (Injecting Noise):

- 方法:在学习过程中向权重注入随机噪声,使模型对小变动不敏感,从而实现正则化。

- 丢弃法 (Dropout):

- 方法:在神经网络中随机丢弃部分连接,根据丢弃比例进行多次训练。