GPTDAOCN-e/acc on Nostr: ...

ķøåµłÉµ£║ÕÖ©ŌÜÖ’ĖÅÕŁ”õ╣ĀĶ»”Ķ¦Ż’╝ÜBaggingŃĆüBoostingõĖÄStackingńÜäÕĤńÉåõĖÄÕ║öńö©Ķ¦Żµ×É

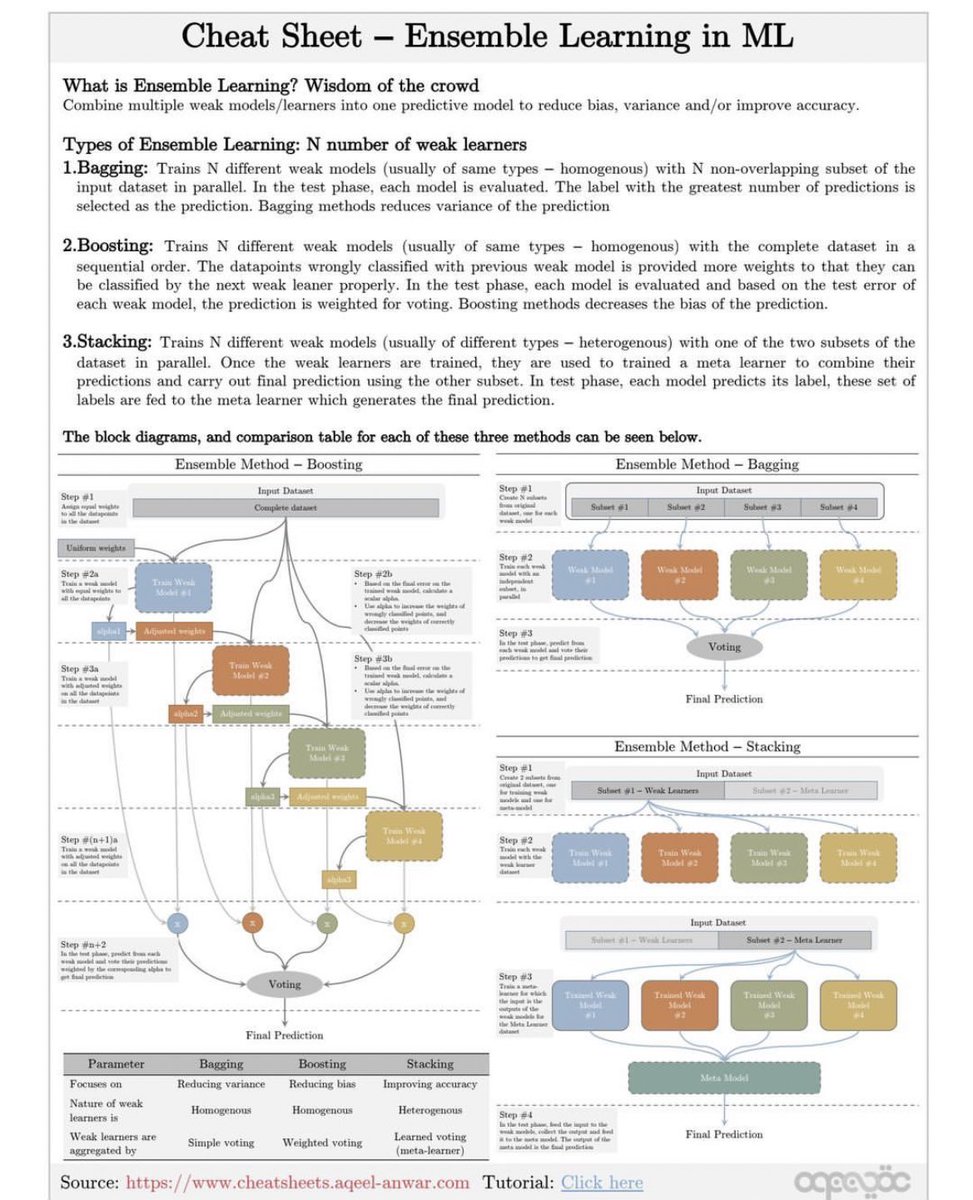

µŹ«https://t.co/St5O59mmxtÕłåµ×É’╝īĶ┐ÖÕ╝Ā"Ensemble Learning in ML"’╝łµ£║ÕÖ©ÕŁ”õ╣ĀõĖŁńÜäķøåµłÉÕŁ”õ╣Ā’╝ēÕżćÕ┐śÕŹĢĶ»”ń╗åõ╗ŗń╗Źõ║åķøåµłÉÕŁ”õ╣ĀńÜäµ”éÕ┐ĄŃĆüń▒╗Õ×ŗõ╗źÕÅŖõĖēń¦ŹõĖ╗Ķ”üµ¢╣µ│ĢńÜ䵥üń©ŗÕÆīµ»öĶŠāŃĆé

õ╗Ćõ╣łµś»ķøåµłÉÕŁ”õ╣Ā’╝¤

ķøåµłÉÕŁ”õ╣Āµś»Õ░åÕżÜõĖ¬Õ╝▒µ©ĪÕ×ŗ/ÕŁ”õ╣ĀÕÖ©ń╗äÕÉłµłÉõĖĆõĖ¬ķó䵥ŗµ©ĪÕ×ŗ’╝īõ╗źÕćÅÕ░æÕüÅÕĘ«ŃĆüµ¢╣ÕĘ«ÕÆī/µł¢µÅÉķ½śÕćåńĪ«µĆ¦ŃĆéĶ┐Öń¦Źµ¢╣µ│ĢĶó½ń¦░õĖ║ŌĆ£ńŠżõĮōµÖ║µģ¦ŌĆØŃĆé

ķøåµłÉÕŁ”õ╣ĀńÜäń▒╗Õ×ŗ’╝ÜNõĖ¬Õ╝▒ÕŁ”õ╣ĀÕÖ©

1. Bagging’╝łĶć¬ÕŖ®µ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīńÜäÕ╝▒µ©ĪÕ×ŗ’╝łķĆÜÕĖĖµś»ÕÉīń▒╗Õ×ŗńÜä’╝īõĖöÕÉīĶ┤©’╝ē’╝īµ»ÅõĖ¬µ©ĪÕ×ŗÕ£©Õ╣ČĶĪīµ¢╣Õ╝ÅõĖŗõĮ┐ńö©ĶŠōÕģźµĢ░µŹ«ķøåńÜäõĖŹķćŹÕÅĀÕŁÉķøåĶ┐øĶĪīĶ«Łń╗āŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīĶ»äõ╝░’╝īķó䵥ŗµĀćńŁŠµĢ░µ£ĆÕżÜńÜäõĮ£õĖ║µ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

- õ╝śńé╣’╝ÜBaggingµ¢╣µ│ĢĶāĮµ£ēµĢłÕćÅÕ░æķó䵥ŗń╗ōµ×£ńÜäµ¢╣ÕĘ«ŃĆé

2. Boosting’╝łµÅÉÕŹćµ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīńÜäÕ╝▒µ©ĪÕ×ŗ’╝łķĆÜÕĖĖµś»ÕÉīń▒╗Õ×ŗńÜä’╝īõĖöÕÉīĶ┤©’╝ē’╝īµīēķĪ║Õ║ÅõŠØµ¼ĪõĮ┐ńö©Õ«īµĢ┤ńÜäµĢ░µŹ«ķøåĶ┐øĶĪīĶ«Łń╗āŃĆéķöÖĶ»»Õłåń▒╗ńÜäµĢ░µŹ«ńé╣õ╝ÜĶó½ĶĄŗõ║łµø┤ķ½śńÜäµØāķ插╝īõ╗źõŠ┐õĖŗõĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗĶāĮÕż¤µø┤ÕźĮÕ£░Õłåń▒╗Ķ┐Öõ║øµĢ░µŹ«ŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīĶ»äõ╝░’╝īÕ╣ȵĀ╣µŹ«µĄŗĶ»ĢĶ»»ÕĘ«Õ»╣µ»ÅõĖ¬µ©ĪÕ×ŗńÜäķó䵥ŗĶ┐øĶĪīÕŖĀµØāµŖĢńź©ŃĆé

- õ╝śńé╣’╝ÜBoostingµ¢╣µ│ĢĶāĮµ£ēµĢłÕćÅÕ░æķó䵥ŗń╗ōµ×£ńÜäÕüÅÕĘ«ŃĆé

3. Stacking’╝łÕĀåÕÅĀµ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīń▒╗Õ×ŗ’╝łÕ╝éĶ┤©’╝ēńÜäÕ╝▒µ©ĪÕ×ŗ’╝īÕ£©Õ╣ČĶĪīµ¢╣Õ╝ÅõĖŗõĮ┐ńö©µĢ░µŹ«ķøåńÜäõĖĆõĖ¬ÕŁÉķøåĶ┐øĶĪīĶ«Łń╗āŃĆéõĖƵŚ”Ķ┐Öõ║øÕ╝▒ÕŁ”õ╣ĀÕÖ©Ķó½Ķ«Łń╗āÕ«īµłÉ’╝īÕ«āõ╗¼õ╝Üńö©ÕÅ”õĖĆõĖ¬ÕŁÉķøåĶ┐øĶĪīķó䵥ŗ’╝īÕ╣Čńö©Ķ┐ÖõĖ¬ÕŁÉķøåĶ┐øĶĪīµ£Ćń╗łķó䵥ŗŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīķó䵥ŗ’╝īĶ┐Öõ║øķó䵥ŗń╗ōµ×£õ╝ÜĶó½ńö©µØźĶ«Łń╗āõĖĆõĖ¬ÕģāÕŁ”õ╣ĀÕÖ©’╝īÕģāÕŁ”õ╣ĀÕÖ©õ╝Üńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

- õ╝śńé╣’╝ÜStackingµ¢╣µ│ĢĶāĮµ£ēµĢłµÅÉķ½śķó䵥ŗÕćåńĪ«µĆ¦ŃĆé

õĖēń¦Źµ¢╣µ│ĢńÜ䵥üń©ŗÕøŠÕÆīµ»öĶŠāĶĪ©

BoostingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåŃĆé

2. Ķ«Łń╗āń¼¼õĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗŃĆé

3. µĀ╣µŹ«ń¼¼õĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ░āµĢ┤ķććµĀʵØāķćŹŃĆé

4. ķćŹÕżŹµŁźķ¬ż2-3’╝īńø┤Õł░µēƵ£ēÕ╝▒µ©ĪÕ×ŗķāĮĶó½Ķ«Łń╗āÕ«īµłÉŃĆé

5. Õ»╣µēƵ£ēÕ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ┐øĶĪīÕŖĀµØāµŖĢńź©’╝īńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

BaggingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåŃĆé

2. Õ░åµĢ░µŹ«ķøåÕłÆÕłåõĖ║õĖŹķćŹÕÅĀÕŁÉķøå’╝īµ»ÅõĖ¬ÕŁÉķøåńö©õ║ÄĶ«Łń╗āõĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗŃĆé

3. µ»ÅõĖ¬Õ╝▒µ©ĪÕ×ŗńŗ¼ń½ŗÕ£░Õ£©ÕģČÕ»╣Õ║öÕŁÉķøåõĖŁĶ┐øĶĪīĶ«Łń╗āŃĆé

4. Õ»╣µēƵ£ēÕ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ┐øĶĪīń«ĆÕŹĢµŖĢńź©’╝īńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

StackingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåÕ╣ČÕłÆÕłåõĖ║õĖżõĖ¬ÕŁÉķøå’╝īõĖĆõĖ¬ńö©õ║ÄĶ«Łń╗āÕ╝▒ÕŁ”õ╣ĀÕÖ©’╝īõĖĆõĖ¬ńö©õ║ÄÕģāÕŁ”õ╣ĀÕÖ©ŃĆé

2. Õ£©ń¼¼õĖĆõĖ¬ÕŁÉķøåõĖŁÕ╣ČĶĪīĶ«Łń╗āÕżÜõĖ¬õĖŹÕÉīń▒╗Õ×ŗńÜäÕ╝▒ÕŁ”õ╣ĀÕÖ©ŃĆé

3. ńö©ń¼¼õ║īõĖ¬ÕŁÉķøåÕ»╣µēƵ£ēÕ╝▒ÕŁ”õ╣ĀÕÖ©Ķ┐øĶĪīĶ»äõ╝░’╝īÕ╣Čńö¤µłÉõĖŁķŚ┤ķó䵥ŗń╗ōµ×£ŃĆé

4. Ķ┐Öõ║øõĖŁķŚ┤ķó䵥ŗń╗ōµ×£ńö©µØźĶ«Łń╗āÕģāÕŁ”õ╣ĀÕÖ©’╝īńö¤µłÉµ£Ćń╗ł

µĆ╗õ╣ŗ’╝īµŹ«https://t.co/St5O59mmxtÕłåµ×É’╝īĶ┐ÖÕ╝ĀÕżćÕ┐śÕŹĢµĖģµÖ░Õ£░Õ▒Ģńż║õ║åõĖēń¦ŹõĖ╗Ķ”üńÜäķøåµłÉÕŁ”õ╣Āµ¢╣µ│ĢÕÅŖÕģČńē╣ńé╣’╝īõĖ║ńö©µłĘµÅÉõŠøõ║åµ£ēµĢłķĆēµŗ®ÕÆīÕ║öńö©Ķ┐Öõ║øµ¢╣µ│ĢńÜäķćŹĶ”üÕÅéĶĆāŃĆé

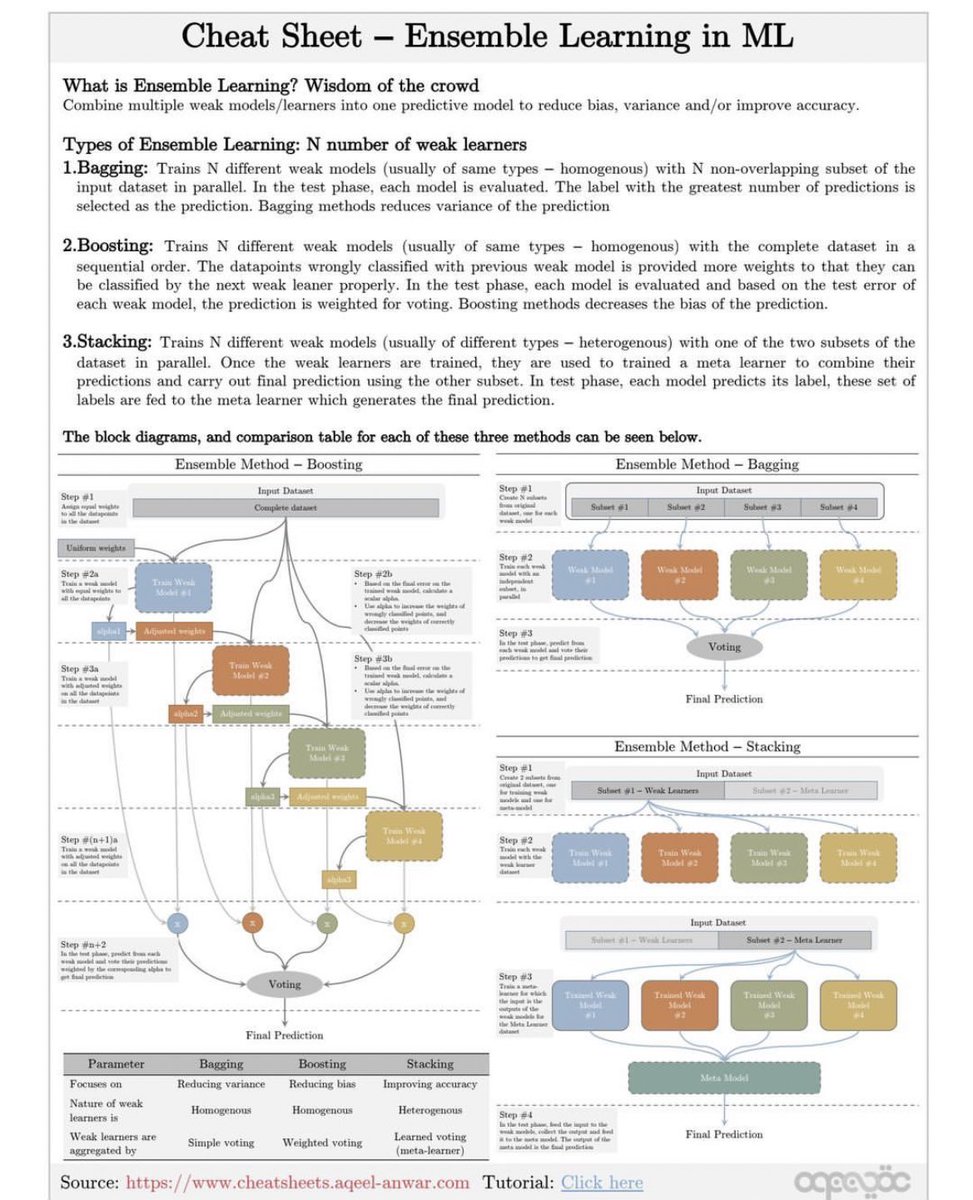

µŹ«https://t.co/St5O59mmxtÕłåµ×É’╝īĶ┐ÖÕ╝Ā"Ensemble Learning in ML"’╝łµ£║ÕÖ©ÕŁ”õ╣ĀõĖŁńÜäķøåµłÉÕŁ”õ╣Ā’╝ēÕżćÕ┐śÕŹĢĶ»”ń╗åõ╗ŗń╗Źõ║åķøåµłÉÕŁ”õ╣ĀńÜäµ”éÕ┐ĄŃĆüń▒╗Õ×ŗõ╗źÕÅŖõĖēń¦ŹõĖ╗Ķ”üµ¢╣µ│ĢńÜ䵥üń©ŗÕÆīµ»öĶŠāŃĆé

õ╗Ćõ╣łµś»ķøåµłÉÕŁ”õ╣Ā’╝¤

ķøåµłÉÕŁ”õ╣Āµś»Õ░åÕżÜõĖ¬Õ╝▒µ©ĪÕ×ŗ/ÕŁ”õ╣ĀÕÖ©ń╗äÕÉłµłÉõĖĆõĖ¬ķó䵥ŗµ©ĪÕ×ŗ’╝īõ╗źÕćÅÕ░æÕüÅÕĘ«ŃĆüµ¢╣ÕĘ«ÕÆī/µł¢µÅÉķ½śÕćåńĪ«µĆ¦ŃĆéĶ┐Öń¦Źµ¢╣µ│ĢĶó½ń¦░õĖ║ŌĆ£ńŠżõĮōµÖ║µģ¦ŌĆØŃĆé

ķøåµłÉÕŁ”õ╣ĀńÜäń▒╗Õ×ŗ’╝ÜNõĖ¬Õ╝▒ÕŁ”õ╣ĀÕÖ©

1. Bagging’╝łĶć¬ÕŖ®µ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīńÜäÕ╝▒µ©ĪÕ×ŗ’╝łķĆÜÕĖĖµś»ÕÉīń▒╗Õ×ŗńÜä’╝īõĖöÕÉīĶ┤©’╝ē’╝īµ»ÅõĖ¬µ©ĪÕ×ŗÕ£©Õ╣ČĶĪīµ¢╣Õ╝ÅõĖŗõĮ┐ńö©ĶŠōÕģźµĢ░µŹ«ķøåńÜäõĖŹķćŹÕÅĀÕŁÉķøåĶ┐øĶĪīĶ«Łń╗āŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīĶ»äõ╝░’╝īķó䵥ŗµĀćńŁŠµĢ░µ£ĆÕżÜńÜäõĮ£õĖ║µ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

- õ╝śńé╣’╝ÜBaggingµ¢╣µ│ĢĶāĮµ£ēµĢłÕćÅÕ░æķó䵥ŗń╗ōµ×£ńÜäµ¢╣ÕĘ«ŃĆé

2. Boosting’╝łµÅÉÕŹćµ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīńÜäÕ╝▒µ©ĪÕ×ŗ’╝łķĆÜÕĖĖµś»ÕÉīń▒╗Õ×ŗńÜä’╝īõĖöÕÉīĶ┤©’╝ē’╝īµīēķĪ║Õ║ÅõŠØµ¼ĪõĮ┐ńö©Õ«īµĢ┤ńÜäµĢ░µŹ«ķøåĶ┐øĶĪīĶ«Łń╗āŃĆéķöÖĶ»»Õłåń▒╗ńÜäµĢ░µŹ«ńé╣õ╝ÜĶó½ĶĄŗõ║łµø┤ķ½śńÜäµØāķ插╝īõ╗źõŠ┐õĖŗõĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗĶāĮÕż¤µø┤ÕźĮÕ£░Õłåń▒╗Ķ┐Öõ║øµĢ░µŹ«ŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīĶ»äõ╝░’╝īÕ╣ȵĀ╣µŹ«µĄŗĶ»ĢĶ»»ÕĘ«Õ»╣µ»ÅõĖ¬µ©ĪÕ×ŗńÜäķó䵥ŗĶ┐øĶĪīÕŖĀµØāµŖĢńź©ŃĆé

- õ╝śńé╣’╝ÜBoostingµ¢╣µ│ĢĶāĮµ£ēµĢłÕćÅÕ░æķó䵥ŗń╗ōµ×£ńÜäÕüÅÕĘ«ŃĆé

3. Stacking’╝łÕĀåÕÅĀµ│Ģ’╝ē’╝Ü

- ÕĤńÉå’╝ÜĶ«Łń╗āNõĖ¬õĖŹÕÉīń▒╗Õ×ŗ’╝łÕ╝éĶ┤©’╝ēńÜäÕ╝▒µ©ĪÕ×ŗ’╝īÕ£©Õ╣ČĶĪīµ¢╣Õ╝ÅõĖŗõĮ┐ńö©µĢ░µŹ«ķøåńÜäõĖĆõĖ¬ÕŁÉķøåĶ┐øĶĪīĶ«Łń╗āŃĆéõĖƵŚ”Ķ┐Öõ║øÕ╝▒ÕŁ”õ╣ĀÕÖ©Ķó½Ķ«Łń╗āÕ«īµłÉ’╝īÕ«āõ╗¼õ╝Üńö©ÕÅ”õĖĆõĖ¬ÕŁÉķøåĶ┐øĶĪīķó䵥ŗ’╝īÕ╣Čńö©Ķ┐ÖõĖ¬ÕŁÉķøåĶ┐øĶĪīµ£Ćń╗łķó䵥ŗŃĆéÕ£©µĄŗĶ»ĢķśČµ«Ą’╝īµ»ÅõĖ¬µ©ĪÕ×ŗńŗ¼ń½ŗĶ┐øĶĪīķó䵥ŗ’╝īĶ┐Öõ║øķó䵥ŗń╗ōµ×£õ╝ÜĶó½ńö©µØźĶ«Łń╗āõĖĆõĖ¬ÕģāÕŁ”õ╣ĀÕÖ©’╝īÕģāÕŁ”õ╣ĀÕÖ©õ╝Üńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

- õ╝śńé╣’╝ÜStackingµ¢╣µ│ĢĶāĮµ£ēµĢłµÅÉķ½śķó䵥ŗÕćåńĪ«µĆ¦ŃĆé

õĖēń¦Źµ¢╣µ│ĢńÜ䵥üń©ŗÕøŠÕÆīµ»öĶŠāĶĪ©

BoostingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåŃĆé

2. Ķ«Łń╗āń¼¼õĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗŃĆé

3. µĀ╣µŹ«ń¼¼õĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ░āµĢ┤ķććµĀʵØāķćŹŃĆé

4. ķćŹÕżŹµŁźķ¬ż2-3’╝īńø┤Õł░µēƵ£ēÕ╝▒µ©ĪÕ×ŗķāĮĶó½Ķ«Łń╗āÕ«īµłÉŃĆé

5. Õ»╣µēƵ£ēÕ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ┐øĶĪīÕŖĀµØāµŖĢńź©’╝īńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

BaggingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåŃĆé

2. Õ░åµĢ░µŹ«ķøåÕłÆÕłåõĖ║õĖŹķćŹÕÅĀÕŁÉķøå’╝īµ»ÅõĖ¬ÕŁÉķøåńö©õ║ÄĶ«Łń╗āõĖĆõĖ¬Õ╝▒µ©ĪÕ×ŗŃĆé

3. µ»ÅõĖ¬Õ╝▒µ©ĪÕ×ŗńŗ¼ń½ŗÕ£░Õ£©ÕģČÕ»╣Õ║öÕŁÉķøåõĖŁĶ┐øĶĪīĶ«Łń╗āŃĆé

4. Õ»╣µēƵ£ēÕ╝▒µ©ĪÕ×ŗńÜäĶŠōÕć║Ķ┐øĶĪīń«ĆÕŹĢµŖĢńź©’╝īńö¤µłÉµ£Ćń╗łķó䵥ŗń╗ōµ×£ŃĆé

StackingµĄüń©ŗÕøŠ’╝Ü

1. ĶŠōÕģźµĢ░µŹ«ķøåÕ╣ČÕłÆÕłåõĖ║õĖżõĖ¬ÕŁÉķøå’╝īõĖĆõĖ¬ńö©õ║ÄĶ«Łń╗āÕ╝▒ÕŁ”õ╣ĀÕÖ©’╝īõĖĆõĖ¬ńö©õ║ÄÕģāÕŁ”õ╣ĀÕÖ©ŃĆé

2. Õ£©ń¼¼õĖĆõĖ¬ÕŁÉķøåõĖŁÕ╣ČĶĪīĶ«Łń╗āÕżÜõĖ¬õĖŹÕÉīń▒╗Õ×ŗńÜäÕ╝▒ÕŁ”õ╣ĀÕÖ©ŃĆé

3. ńö©ń¼¼õ║īõĖ¬ÕŁÉķøåÕ»╣µēƵ£ēÕ╝▒ÕŁ”õ╣ĀÕÖ©Ķ┐øĶĪīĶ»äõ╝░’╝īÕ╣Čńö¤µłÉõĖŁķŚ┤ķó䵥ŗń╗ōµ×£ŃĆé

4. Ķ┐Öõ║øõĖŁķŚ┤ķó䵥ŗń╗ōµ×£ńö©µØźĶ«Łń╗āÕģāÕŁ”õ╣ĀÕÖ©’╝īńö¤µłÉµ£Ćń╗ł

µĆ╗õ╣ŗ’╝īµŹ«https://t.co/St5O59mmxtÕłåµ×É’╝īĶ┐ÖÕ╝ĀÕżćÕ┐śÕŹĢµĖģµÖ░Õ£░Õ▒Ģńż║õ║åõĖēń¦ŹõĖ╗Ķ”üńÜäķøåµłÉÕŁ”õ╣Āµ¢╣µ│ĢÕÅŖÕģČńē╣ńé╣’╝īõĖ║ńö©µłĘµÅÉõŠøõ║åµ£ēµĢłķĆēµŗ®ÕÆīÕ║öńö©Ķ┐Öõ║øµ¢╣µ│ĢńÜäķćŹĶ”üÕÅéĶĆāŃĆé